Rate me again

Si vous aviez raté le lancement de cette réflexion en 2018, le post traitant du 1er atelier ‘RateMe’ est ici et le site ou nous consignons nos réflexions sur le sujet est temporairement ici.

En 2019, nous avons ré-itéré ce dispositif avec 3 groupes différents. Le panel des technos passé en revue est le même et chaque groupe a trouvé là un axe original de réflexion.

Les leçons à tirer de ces animations autour du « paysage digital » qui se dessinent petit-à-petit autour de chacun ne sont pas définitives. Elles évoluent avec le contexte, les connaissances acquises, les avancements technologiques, la réflexion politique, écologique, sociologique du temps présent.

Les groupes :

-Le groupe Avanti-Marchienne a poussé sa réflexion vers les possibilités de construire des applications « qui changent le monde » à partir du croisement et de l’exploitation des données générées dans plusieurs domaines.Caroline Christopher Cyriaque François Julien Laetitia Olivia

-Le groupe 6PO de Marchienne s’est penché sur les votes. Ils ont surtout accroché à la dimension interpersonnelle à grande échelle et imaginé l’application qui permettrait de tous s’auto-évaluer, jusqu’à l’auto-censure… Les notes données ont représenté un enjeu stratégique, les participants cherchant à finir leader du classement (et c’est Jesse qui a gagné : quelle diplomatie!) vers l’application générée

– 2 Groupes d’enfants en stage « Robokids » : En deux séances, nous avons réfléchi à nos consommations et aux mondes virtuels fréquentés avec ou sans les parents. Les enfants sont nés dans ces technos et elles leur semblent tout-à-fait naturelles. Nous avons parler du libre-arbitre en présence d’un ordinateur/téléphone. Les enfants ont rapproché la problématique avec celle qui ont découvert dans le film d’animation « Emojis ». lien notes

–Le groupe Carrefour-Couvin s’est penchée sur le déploiement de technologies sur un territoire rural en consignant leurs idées sur une carte, ils ont pris la mesure d’un certain manque de régulation à l’heure actuelle.

Nous pouvons néanmoins partager ici les premières conclusions qui ressortent de ce travail.

réflexions citoyennes

Les algorithmes sont partout : ils sont donc l’affaire de tous.

Il faut que l’humain garde le contrôle sur le développement des algorithmes. Ceci implique un principe de vigilance par rapport au développement de l’IA.

Ethic by design : les développeurs opèrent dans un milieu professionnel hyper concurrentiel et, nous l’avons vu en profondeur, c’est la pub qui paie une partie du web en échange et de notre attention. Ce règne de la pub et du profit ne peut s’étendre aux algorithmes qui touchent à la sphère publique !

Une manière de mettre de l’éthique dans le code est urgemment à penser.

Besoin de savoir et de comprendre : plus d’éducation au numérique tout au long de la vie.

Ce que l’on a commencé à entrevoir dans les ateliers du Gsara est parfois effrayant. Les citoyens se doivent de tenter d’appréhender l’étendue du monde digital en expansion. Si il ne le font pas pour eux, il devraient le faire pour leurs enfants. Un programme scolaire remanié est d’ailleurs aussi évoqué.

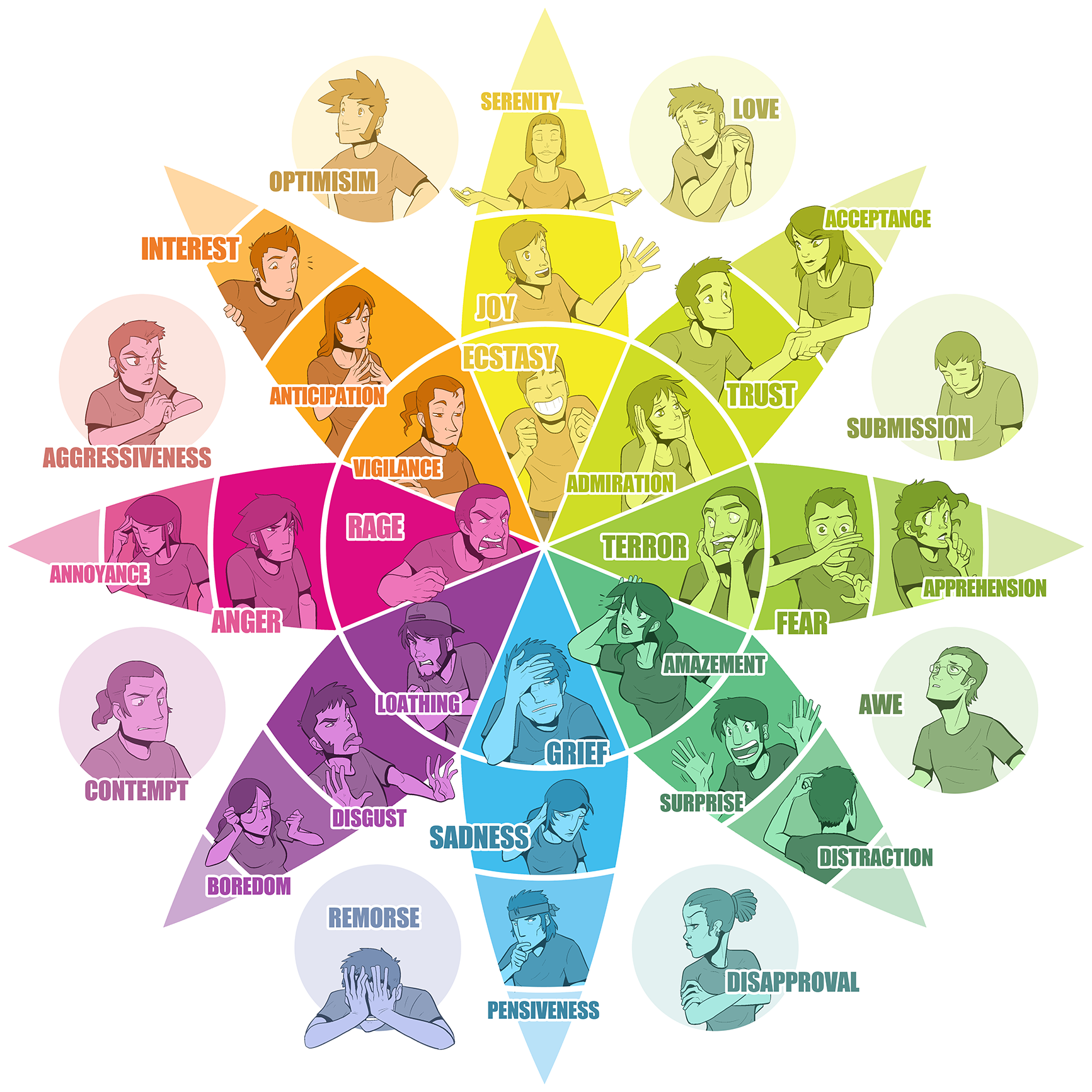

Observant les systèmes algorithmiques aujourd’hui en application tels que ceux de Google ou de Facebook, nous constatons que l’apport humain est trop souvent suscité par les biais de l’émotion.

L’engagement aujourd’hui mesuré et provoqué par ces systèmes se basent sur des réponses-réflexes à des stimulus massivement balancés sur nos écrans. Physiquement absents mais comptés dans le contingent des personnes « impactées », nos doubles numériques voyagent avec nos données dans des bulles et des listes, atteignant sur ces vaisseaux des rivages probables et automatiquement générés.

Avoir la possibilité de comparer nos « personnalisations », nos bulles et nos statistiques doivent nous permettre de comprendre ce qui se passe entre la publication et l’affichage d’une info.

Quel rôle, quel traitement et quelle limites sont imputables aux « infomédiaires » ? Qu’est-ce qui est généré avec l’info suivie ?

Pouvoir disposer de droits renforcés en matière d’information, de transparence et d’explication quant à la logique de fonctionnement de l’algorithme.

Où est l’agence nationale de contrôle algorithmique? Les participants s’étonnent du manque de cadre législatif dans le domaine de la récolte et du traitement des informations. Au delà du récent RGPD européen, les participants ont souvent marqué la responsabilité de l’état belge qui prend rarement l’initiative dans ce domaine. Ils pointent aussi l’enthousiasme naïf de la région wallonne qui semblent vouloir confier au seul secteur privé la digitalisation de nos territoires.

Faisant suite à l’idée précédente, nous avons également souvent pointé un nécessaire « audit permanent » des algorithmes. En effet, un système est parfois mis en branle et se met à produire plein de données. Quelques années plus tard, le traitement est-il toujours adapté à la situation ( typiquement avec les objets technos qui se renouvellent très vite) ? La collecte est-elle encore nécessaire ? Se fait-elle sur une structure ad-hoc ? Les personnes touchées sont-elles toujours informées ?

Avant de donner un blanc-seing aux entreprises pour se développer sur notre territoire, ne devrait-on pas s’équiper d’une instance de contrôle, d’audit des productions algorithmiques ?

La protection de la vie privée des individus semble être la clé de voute des raisonnements actuels. Mais les publics pressentent et redoutent la mise en place de collectes et de traitements à l’échelle des territoires, autrefois symbolisés par l’Etat et des frontières. Ces barrières n’existant plus vraiment dans le monde digital, un pressentiment d' »évasion » de nos données personelles a été souvent évoqué. Poussé à bout, cette inquiétude se transforme en crainte pour notre système sociétal tout entier, en crise civilisationnelle.

Les machines, plus rapides, nous donnerons-t-elles le tempo? Et qu’advient-il de ceux qui ne veulent ou ne peuvent suivre ce tempo ?

Un autre danger identifié au cours des ateliers est la « paresse naturelle » que nous manifestons au contact des technologies

Qui mémorise encore les numéros de téléphone de ses amis ? Plus personne…. Que répondrons-nous aux systèmes qui dressent des listes (IBM 1941), croisent les données et font émerger des « patterns » ou « figures » dans notre monde ?

Cette immanence d’un paysage en constante évolution, en constant calcul met au défi notre imagination, notre objectivité et notre mémoire d’être humain (comme l’invention de l’écriture ou de l’impression automatique en leurs temps).

Ces nouvelles « réalités » en sont-elles vraiment ? Les algorithmes font des calculs et nous semblent donc « rationnels ». Comment ce concept-clé de notre développement scientifique va-t-il évoluer sous le règne des super-ordinateurs ? Le monde aura-t-il encore un sens sans eux ? Pourra-t-on faire le grand écart entre un monde physique incertain et en devenir et un monde « calculé » et pré-construit par des systèmes plus « intelligents » que nous ?

Cette question sous-tend au final toutes les interrogations et toutes les conclusions de fins d’animation : que sommes-nous en train de bâtir pour nos enfants ?